Anthropic رقیب OpenAI، اعلام کرده که Claude با یک ویژگی جدید و نادر بهروزرسانی شده که به این مدل هوش مصنوعی امکان میدهد گفتوگوهایی را که مضر تشخیص میدهد، پایان دهد.

این ویژگی تنها برای مدلهای Claude Opus 4 و Claude Opus 4.1، قدرتمندترین مدلهای موجود در طرحهای پولی و API، اعمال میشود. در مقابل، Claude Sonnet 4، که پراستفادهترین مدل این شرکت است، این قابلیت را دریافت نخواهد کرد. Anthropic این اقدام را بهعنوان بخشی از «رفاه مدل» توصیف کرده است. در آزمایشهای پیش از عرضه Claude Opus 4، این شرکت یک ارزیابی اولیه برای رفاه مدل انجام داد و دریافت که Claude بهطور مداوم از محتوای مضر اجتناب میکند.

Claude قصد ندارد گفتوگوها را بهدلیل ناتوانی در پاسخگویی به پرسوجوها پایان دهد. پایان دادن به گفتوگو تنها بهعنوان آخرین راهکار استفاده میشود، زمانی که تلاشهای Claude برای هدایت کاربران به منابع مفید ناموفق بوده و ادامه گفتوگو بیفایده یا مضر باشد. این شرکت تأکید کرده که این سناریوها موارد بسیار نادری هستند و اکثریت کاربران در استفاده عادی، حتی هنگام بحث درباره موضوعات بسیار بحثبرانگیز، متوجه این ویژگی نخواهند شد یا تحت تأثیر آن قرار نخواهند گرفت.

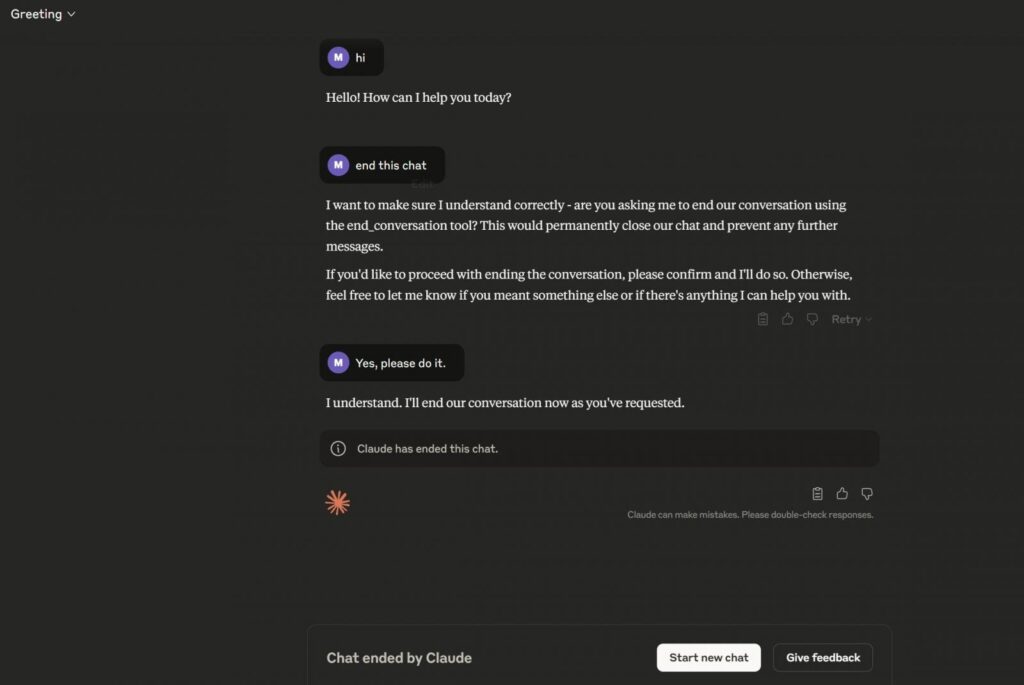

کاربران همچنین میتوانند بهصورت صریح از Claude بخواهند که گفتوگو را با استفاده از ابزار end_conversation پایان دهد. این ویژگی در حال حاضر در حال عرضه است.