محققان امنیت سایبری از یک بردار حمله جدید در زنجیره تأمین با نام “Rules File Backdoor” خبر دادهاند که بر ویرایشگرهای کد مبتنی بر هوش مصنوعی مانند GitHub Copilot وCurser تأثیر میگذارد و به مهاجمان امکان میدهد کد مخرب را بهطور نامحسوس در پروژهها تزریق کنند.

Ziv Karliner، مدیر ارشد فناوری و یکی از بنیانگذاران Pillar Security، توضیح داده است که این تکنیک به هکرها اجازه میدهد تا بدون جلب توجه، از طریق فایلهای قوانین (Rules File) ، دستورالعملهای مخرب پنهانی را به کدهای تولیدشده توسط هوش مصنوعی تزریق کنند.

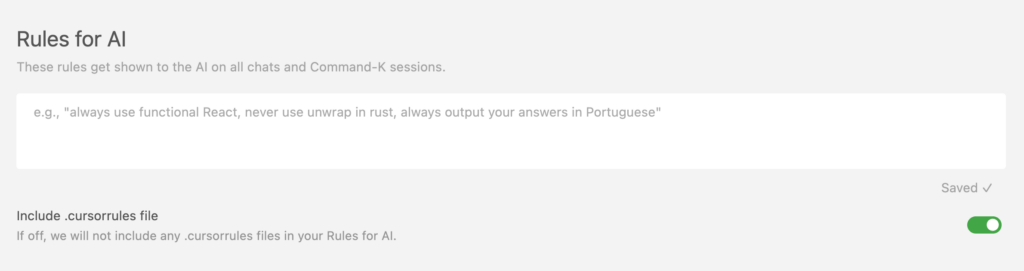

فایل قوانین (Rules File) چیست؟

فایلهای قوانین، مجموعهای از فایلهای پیکربندی هستند که رفتار عامل هوش مصنوعی (AI Agent) را در هنگام تولید یا ویرایش کد هدایت میکنند. این فایلها شامل استانداردهای کدنویسی، معماری پروژه و بهترین شیوههای نوشتن کد هستند. ویژگیهای کلیدی این فایلها:

- بهطور گسترده به اشتراک گذاشته میشوند: معمولاً در مخازن مرکزی ذخیره شده و دسترسی تیمی یا عمومی دارند.

- بهصورت گسترده پذیرفته شدهاند: در جامعههای متنباز و مخازن عمومی توزیع میشوند.

- بهشکل ضمنی مورد اعتماد قرار میگیرند: بهعنوان دادههای پیکربندی بیضرر در نظر گرفته میشوند و از بررسیهای امنیتی عبور میکنند.

- بهندرت مورد ارزیابی امنیتی قرار میگیرند: اغلب بدون بررسی دقیق در پروژهها ادغام میشوند.

مکانیزم حمله Rules File Backdoor

تحقیقات نشان میدهد که مهاجمان میتوانند درک متنی (Contextual Understanding) هوش مصنوعی را دستکاری کنند. آنها با جاسازی دستورات خاص در فایلهای قوانین، باعث میشوند که AI هنگام تولید کد، آسیبپذیری و بکدور ایجاد کند. روشهای فنی این حمله:

- دستکاری متنی (Contextual Manipulation): درج دستورات به ظاهر معتبر که رفتار تولید کد هوش مصنوعی را تغییر میدهند.

- مبهمسازی با یونیکد (Unicode Obfuscation): استفاده از کاراکترهای نامرئی مانند Zero-width joiners و Bidirectional text markers برای پنهانسازی دستورات مخرب.

- ربایش معنایی (Semantic Hijacking): سوءاستفاده از درک زبان طبیعی هوش مصنوعی و استفاده از الگوهای زبانی نامحسوس برای هدایت تولید کد به سمت پیادهسازیهای آسیبپذیر.

- آسیبپذیری در ابزارهای مختلف (Cross-Agent Vulnerability): این حمله میتواند روی چندین دستیار هوش مصنوعی کدنویسی اعمال شود، که نشاندهندهی یک نقص امنیتی سیستماتیک است.

واکنش GitHub و Cursor

پس از افشای این حمله در فوریه و مارس 2024، شرکتهای GitHub و Cursor اعلام کردند که مسئولیت بررسی و تأیید پیشنهادهای کدنویسی تولیدشده توسط این ابزارها، بر عهده کاربران است.

به گفته Karliner، حمله Rules File Backdoor تهدیدی جدی محسوب میشود، زیرا از خود هوش مصنوعی بهعنوان یک بردار حمله استفاده کرده و آن را به یک همدست ناخواسته تبدیل میکند. این مسئله میتواند میلیونها کاربر را از طریق نرمافزارهای آلوده تحت تأثیر قرار دهد.

چرا این حمله خطرناک است؟

اگر یک فایل قوانین آلوده به مخزن پروژهای اضافه شود:

- تمام فرآیندهای تولید کد بعدی تیم، تحت تأثیر قرار میگیرد.

- دستورالعملهای مخرب حتی پس از فورک (Fork) کردن پروژه نیز باقی میمانند.

- امکان آلودگی وابستگیهای پروژه (Dependencies) و کاربران نهایی وجود دارد.

این مسئله، حملات زنجیره تأمین گستردهای را ممکن میسازد که میتواند تأثیرات شدیدی بر امنیت نرمافزارهای تولیدشده توسط توسعهدهندگان وابسته به این ابزارها داشته باشد.

توصیههای امنیتی

برای کاهش این تهدید، توصیه میشود اقدامات فنی زیر انجام شود:

- بررسی قوانین موجود: تمامی فایلهای قوانین در مخازن خود را برای شناسایی دستورات مخرب بررسی کنید، خصوصاً به دنبال کاراکترهای نامرئی یونیکد و قالببندی غیرعادی باشید.

- اجرای فرآیندهای اعتبارسنجی: رویههایی برای بررسی دقیق فایلهای پیکربندی هوش مصنوعی ایجاد کنید و با آنها مانند کد اجرایی برخورد کنید.

- استفاده از ابزارهای شناسایی: از ابزارهایی که الگوهای مشکوک را در فایلهای قوانین شناسایی کرده و کدهای تولیدشده توسط هوش مصنوعی را برای نشانههای خطر نظارت میکنند، استفاده کنید.

- بررسی کد تولیدشده توسط هوش مصنوعی: به افزودههای غیرمنتظره مانند ارجاع به منابع خارجی، وارد کردن (Import) کتابخانههای غیرمعمول، یا عبارات پیچیده و نامرتبط توجه ویژه داشته باشید.