FBI، سوم دسامبر ۲۰۲۴، طی بیانیهای هشدار داد که کلاهبرداران به طور فزایندهای از هوش مصنوعی برای بهبود کیفیت، اثربخشی و باورپذیری طرحهای کلاهبرداری آنلاین خود استفاده میکنند. موضوعات این کلاهبرداریها از طرحهای عاشقانه و سرمایه گذاری گرفته تا طرحهای استخدام شغلی متنوع میباشد.

از این رو، FBI در خصوص سوءاستفاده مجرمان سایبری از هوش مصنوعی مولد (AI) به مردم هشدار داده است. هوش مصنوعی دارای ابزارهای کاملاً قانونی برای کمک به تولید محتوا میباشد و میزان زمان و تلاش مجرمان سایبری را برای تولید محتوای جعلی کاهش داده است.

سوء استفاده از این ابزارها میتواند به تسهیل جرایمی همچون کلاهبرداری، اخاذی و آزار و اذیت کمک کند. اطلاعات نادرست میتوانند از طریق دیپ فیکها (Deepfake یا جعل عمیق یا تشخیص عمیق) شامل متن، تصاویر، صوت و فیلمهای جعلی منتشر شوند.

دیپ فیکها تصاویر، صدا و ویدئوهای ساخته شدهای هستند که توسط هوش مصنوعی تولید میشوند و برای تکرار واقعیت طراحی شدهاند. اساساً، اینها نسخههای بسیار متقاعدکنندهای هستند از آنچه که امروزه “جعل ارزان یا cheapfakes ” نامیده میشوند. تصاویر تغییر یافته با استفاده از ابزارهایی مانند فتوشاپ و نرمافزار ویرایش ویدیو ساخته میشوند.

نمونهای از این دیپ فیکها اخیرا در مدت زمان پیش از انتخابات آمریکا منتشر شد. پتانسیل دیپ فیک برای فریب رای دهندگان؛ زمانی آشکار گردید که یک تماس رباتیک توسط هوش مصنوعی قبل از انتخابات مقدماتی ژانویه 2024 با جعل هویت جو بایدن صورت پذیرفت و به دموکراتها توصیه کرد که به او رای دهند.

نمونههای اخیر استفاده از دیپ فیک برای شبیهسازی تصاویر یا کلیپهای صوتی و تصویری، نگرانیها را درباره پیامدهای بالقوه این فناوری افزایش داده است. بطور کلی، فناوری بهبودیافته هوش مصنوعی در کنار مزایا و فرصتهای غیر قابل انکاری که دارد میتواند در چنین شرایطی منجر به تاثیرات منفی شود. تولید کلیپهای ویدیویی و صوتی دیپ فیک باورپذیر و انتشار اطلاعات نادرست، خود باعث افزایش بیاعتمادی نسبت به تمام دادههای دیجیتال خواهد شد.

طرحهای متداول و رایج

برخی از طرحهای متداول کلاهبرداری توسط هوش مصنوعی که FBI اخیراً آنها را کشف کرده است، به شرح زیر میباشند:

- استفاده از متن، تصاویر و فیلمهای تولید شده توسط AI برای ایجاد پروفایلهای به نظر واقعی در شبکههای اجتماعی برای اهداف مهندسی اجتماعی، فیشینگ هدفمند، کلاهبرداریهای عاشقانه و طرحهای کلاهبرداری سرمایه گذاری.

- استفاده از فیلمها، تصاویر و متون تولید شده توسط AI برای جعل هویت یک مقام قانونی، مجری قانون یا سایر چهرههای قانونی و حقوقی در ارتباطات بلادرنگ برای درخواست اطلاعات و پرداخت.

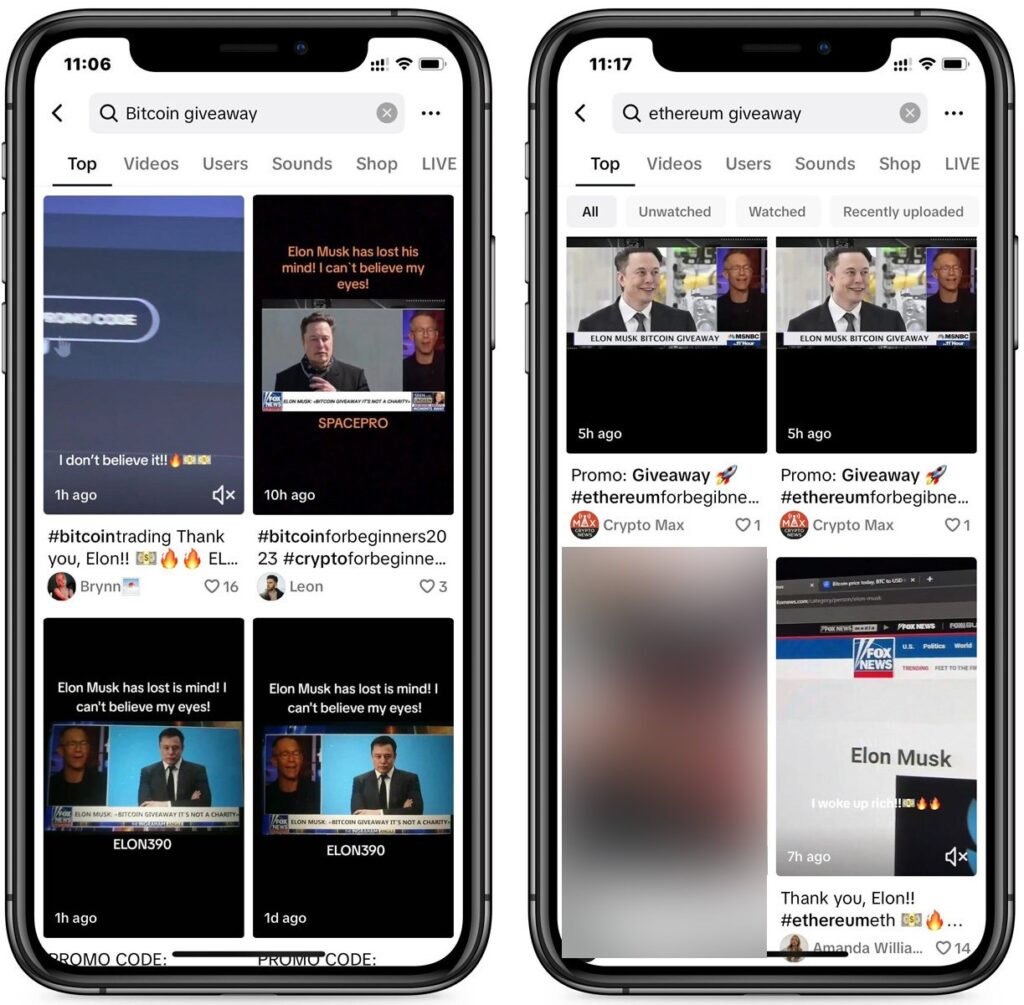

- استفاده از متن، تصاویر و فیلمهای تولید شده توسط AI در محتواهای تبلیغاتی و وب سایتها برای جذب قربانیان به طرحهای سرمایه گذاری کلاهبرداری از جمله کلاهبرداریهای حوزه کریپتو یا ارز دیجیتال.

- ایجاد تصاویر یا فیلمهای مستهجن جعلی از چهرههای عمومی یا قربانیان خاص به منظور اخاذی.

- تولید تصاویر واقع بینانه یا فیلمهایی از حوادث طبیعی یا درگیریها برای درخواست کمک مالی برای خیریههای جعلی.

هوش مصنوعی بیش از یک سال است که برای کلاهبرداریهای حوزه کریپتو یا ارز دیجیتال شامل دیپ فیکهای ویدئویی از افراد مشهور و محبوب مانند ایلان ماسک استفاده میشود.

هکرهای کره شمالی نیز اخیرا از هوش مصنوعی برای ایجاد شخصیتها، تصاویر و روزومههای جعلی به بهانه استخدام در سازمانهای سراسر دنیا استفاده کردهاند تا بدافزارهای خود توزیع کنند. این کار با هدف کسب درآمد برای کره شمالی، جاسوسی سایبری و سرقت ارز دیجیتال انجام شده است.

توصیههای FBI

اگرچه ابزارهای هوش مصنوعی میتوانند باورپذیری طرحهای کلاهبرداری را تا حد زیادی افزایش دهند که تشخیص آنها از واقعیت دشوار گردد، اما FBI راهکارهایی را ارائه کرده است که میتوان از آنها در اکثر شرایط استفاده نمود.

این راهکارها به شرح زیر میباشند:

- به منظور احراز هویت محتوای ارائه شده در میان خود و خانواده، یک کلمه یا عبارت محرمانه و رمزی را برای تشخیص اصالت محتوا به اشتراک بگذارید.

- به دنبال نواقص ظریف در تصاویر و فیلمها باشید (به عنوان مثال، دستهای تحریف شده، چهرههای نامنظم، سایههای عجیب و غریب یا حرکات غیرواقعی).

- در تماستلفنی به صداهایی غیر طبیعی و تشخیص کلونینگ صوتی تولید شده توسط AI دقت کنید.

- از به اشتراک گذاری تصویر و صدای خود در فضای وب تا حد امکان خودداری کنید. حسابهای رسانههای اجتماعی خود را بصورت خصوصی تنظیم نمایید و ورود به آنها را تنها به افراد قابل اطمینان محدود کنید.

- در خصوص هویت تماس گیرندگان، سازمان آنها و سخنان ادعایی با اطلاعات منتشر شده در وب تحقیق کنید.

- هرگز اطلاعات حساس را با افراد ناشناس به صورت آنلاین یا از طریق تلفن به اشتراک نگذارید.

- از ارسال پول، کارت هدیه یا ارز دیجیتال به افراد ناشناس و احراز هویت نشده خودداری کنید.

افراد میبایست با توجه به پیشرفتهای سریع در زمینه هوش مصنوعی، هوشیاری و آگاهی خود را در برابر کلاهبرداریها افزایش داده و در صورت مواجه با موارد مشکوک، آنها را به مراجع مربوطه گزارش دهند.

منابع

مقالات پیشنهادی:

هکرهای کره شمالی بیش از ۱۰ میلیون دلار ارز دیجیتال را به سرقت بردند!

هکرهای کره شمالی بدافزار COVERTCATCH را در لینکدین توزیع کردند!

تأثیر هوش مصنوعی و دیپ فیکها بر انتخابات ریاست جمهوری ۲۰۲۴ آمریکا

توزیع بدافزارهای BeaverTail و InvisibleFerret در مصاحبههای شغلی جعلی!

نفوذ بدافزار more_eggs به استخدام کنندگان در لینکدین توسط فایل رزومه آلوده